前段韶光,由27岁的华裔创始人Alexandr Wang领导的Scale AI刚刚由于融资圈了一波关注。

本日,他又在推特上官宣推出全新LLM排行榜——SEAL,对前沿模型开展专业评估。

SEAL排行榜主打三个特色:

- 私有数据

Scale AI的专有私有评估数据集无法被操控,确保了却果的公道性和无污染。

- 不断发展

定期利用新的数据集和模型更新排行榜,营造一个动态的竞赛环境。

- 专家评估

评估由经由严格审查的专家进行,确保最高的质量和可信度。

榜单地址:https://scale.com/leaderboard

这篇推特得到了Jim Fan大佬的转发,他认为SEAL是LMSys的非常好的补充和参照,供应公开模型的私密、安全、可信的第三方评估。

对此,Andrej Karpathy也深以为然。

代码

在代码任务中,GPT-4 Turbo Preview位列第一,然后是GPT-4o、Gemini 1.5 Pro(Post-I/O)。

而专门演习的代码模型CodeLlama 34B Instruct排在了第11位。

Scale AI编码提示集包含1,000个提示,涵盖各种编程措辞、学科和编程任务,从调试到代码优化,从文档天生到理解繁芜代码库,等等。

诸如HumanEva、Pass@k、MBPP、SWE-Bench、LiveCodeBench等评估基准在首次涌现时很有用,但随着模型开始过拟合,它们已经变得不那么有代价了。

此外,这些模型与这些基准进行评估的方法每每不标准化,缺少跨测试或随韶光比较分数的核心哀求。

Scale编码评估供应了一个标准化的LLM评估框架,能够跨模型进行比较并识别其优缺陷。目前,它涵盖了最常要求的编程措辞的用例集。

代码天生:根据给定的自然措辞规范或描述创建新代码。

代码修复:识别并纠正现有代码中的缺点。例如,调试、办理语法缺点和修复逻辑缺点。

代码理解:阐明、阐明或澄清现有代码。例如,阐明某些代码段的事情事理,分解繁芜算法。

代码修正:对现有代码进行变动或调度以知足新哀求或条件。例如,变动功能,更新或增强特性。

代码优化:提高现有代码的性能。例如,提高效率,减少资源花费(如内存或处理韶光)。

学习赞助:帮助学习或理解编程观点、措辞或工具。例如,供应最佳实践辅导,阐明编程观点。

代码翻译:将代码从一种编程措辞转换为另一种措辞,并根据目标措辞的最佳实践调度代码构造、风格和习惯用法。

建议供应:供应关于编码实践、工具、库或框架的建议或见地。

注释改进:在现有代码中添加或改进注释。

测试开拓:开拓、增强或修复现有代码的测试。

用例分布

编码措辞分布

为了确保评估过程的彻底性和可靠性,每个任务由不同的人工注释员并行实行了三次。

评分经由两个阶段的审查:初步审查层和终极审查层。

这种评估方法不仅天生总体排名,还有助于突出模型在不同领域的上风和劣势,并回答以下问题:

- 模型在SQL、Java、HTML/CSS和C++提示上的表现如何?

- 模型在繁芜场景中的竞争力如何?

评估方法

测试栗子结果剖析模型常日在「注释」和「理解」任务中表现良好,但在「翻译」和「天生」任务中常碰着困难。

此外,「精确性/功能性」和「可读性/文档」也是所有模型的两个紧张缺点来源。

- GPT

两个GPT-4模型在各种用例中表现最为同等。个中,较新的gpt-4o-2024-05-13比较gpt-4-0125-preview更随意马虎涌现可读性问题,有时会不必要地重复提示中的代码,导致相应更加冗长。

- Gemini

所有三个Gemini模型在建议任务中表现出色,分别排名第1、第2和第3,但在测试任务中表现较差。新的gemini-1.5-pro-preview-0514比较之前的gemini-1.5-pro-preview-0409有显著提升,特殊是在「精确性/功能性」和「可读性/文档」方面。

- Claude

claude-3-opus-20240229常日比claude-3-sonnet-20240229表现更好,特殊是在「精确性/功能性」种别中缺点更少,除了某些翻译任务。

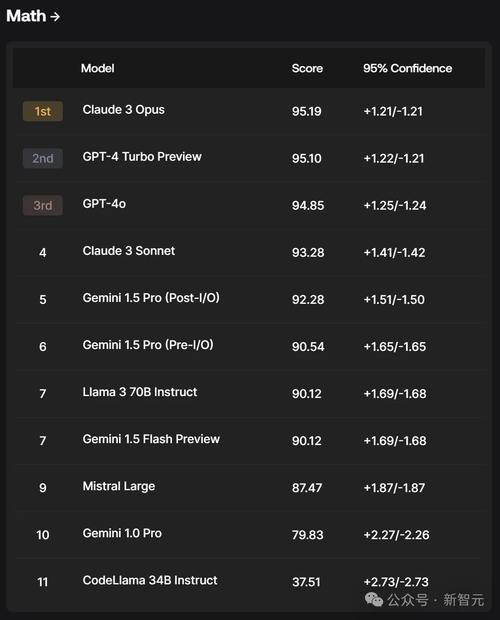

数学

在数学分类榜中,Claude 3 Opus竟打败了GPT-4 Turbo Preview霸占榜首,然后第三名是GPT-4o.

其余,Claude 3的「中杯」模型Sonnet,都超过了Gemini系列的模型。

不得不说,在数学这块,还是Claude3是王者。

数学和推理仍旧是当前大措辞模型(LLM)面临的紧张未办理问题之一。然而,现有的公共基准如GSM8k却存在着致命的数据污染问题。

为全面评估模型的各方面能力,Scale AI设计了一个全新的数学和推理数据集——GSM1k。

GSM1k基于GSM8k基准的分布和难度,并引入全新的一组问题。个中,包含了一系列相称于五年级数学考试水平的数学问题。

它的构建花了不到3周的韶光,标注团队的成员包括小学数学教诲者和具有教诲、数据剖析、打算机科学、物理和经济学背景的专家。

值得把稳的是,GSM1k的数据网络过程并没有用到LLM的帮助。

此外,为了防止模型在GSM1k上过拟合,团队决定仅公开1,000个问题中的50个样本。

测试栗子

指令跟随

针对模型指令跟随测试,GPT-4o、GPT-4 Turbo Preview、Llama 3 70B Instruct分别跃居前三。

同时,Mistral Large的实力也不输其他的模型。

这解释在能否准确遵照人类提示方面,GPT-4系列模型还是更厉害些。

Scale AI精确指令跟随提示数据集包含1,054个指令跟随提示,目的是评估AI模型阐明和实行详细命令的能力,重点在于精确性和详细性,并办理过拟合问题。

数据集中的提示共分为9类,包括「扮演……的角色」、内容创作和头脑风暴,并涵盖指令跟随任务的实际运用和用例。

它由一个40多名人工标注员组成的多样化团队天生,并通过五个步骤的开拓,确保提示能够测试模型理解和实行详细指令的能力。

终极,实现对模型对这些提示集的相应进行人工评估。

测试栗子

西班牙语

在西班牙语测试上,GPT-4o霸榜第一,而Gemini 1.5 Pro(Post-I/O)超过了GPT-4 Turbo Preview。

随后,Gemini其余两个模型也进入榜单前五。

在Scale AI多措辞提示数据集中,每个语种都包含1,000个提示,目的是提升模型在多种措辞中的交互能力。

数据集特殊针对西班牙用户,包括来自西班牙、墨西哥和拉丁美洲其他地区的用户。

虽然排行榜目前只包含西班牙语,但在未来的更新中,会扩展到更多措辞。

方法

如何打算Elo评分排名

在评估过程中,人工评审会比较两个模型对同一提示的回答,并在多个方面评估哪个更好。根据这些评分,便可以确定哪个模型赢了、哪个输了,或者打平。

此外,团队还采取了与Chatbot Arena相同的方法,利用Bradley-Terry模型对我们的数据点进行重新权重的最大似然估计。

首先是一些定义:

对付个模型,用={(,′):<′, and ,′∈[]}表示比较数据集。

在∈时,向人工评审供应一对模型∈,并记录评审的回应∈[0,0.5,1]。

个中,1表示模型优于模型′,而0.5则表示两个模型同样受欢迎。

通过Bradley-Terry,利用逻辑关系来仿照这种情形发生的概率:

个中,是一个M长的BT系数向量。然后,通过最小化二元交叉熵丢失来估计BT系数:

个中,是二进制交叉熵丢失:

(ℎ,)=−(ℎlog()+(1−ℎ)log(1−))

此外,还需利用反向加权()来最小化这一丢失,目标是使分数在上呈现均匀分布。只管这种反向加权并不是绝对必要的,由于模型之间的成比拟较已经非常靠近相等。

接着,利用下面的公式来打算终极的BT分数:

个中~。利用大略转换1000+(^)×400将该分数转换为Elo评分,然后进行排序,得出终极排名。

置信区间为了更好地理解Elo评分的Bradley-Terry评级的可靠性,团队利用自举法(Bootstrapping)来估计置信区间。自举法是一种重采样技能,通过从数据中反复抽样来评估估计值的变异性。

1. 天生自举样本:从数据集中反复抽样,天生多个自举样本。每个样本的大小与原始数据集相同,但由于重采样的特性,样本中会包含一些重复的不雅观测值。

2. 打算每个样本的Elo评分:对付每个自举样本,利用前面提到的最大似然估计方法来打算Elo评分。

3. 汇总结果:在打算了大量自举样本的Elo评分(例如1000轮)后,汇总这些结果,估计每个模型的Elo评疏散布。

4. 估计置信区间:根据汇总的自举结果,确定每个模型的Elo评分的置信区间。

LLM评估的主要性

Karpathy在转发Wang的推特时,打了很长一段笔墨,描述LLM评估的困难与主要性。

LLM评估正在改进,但不久前他们的状态非常黯淡,定性履历常常与定量排名不一致。

这是由于良好的评估非常难以构建。

在特斯拉,我可能将1/3的韶光花在数据上,1/3的韶光花在评估上,1/3 的韶光花在其他事情上。评估必须全面、有代表性、高质量,并丈量梯度旗子暗记(即梯度低落不能太随意马虎,也不能太难)。而且将定性和定量评估对齐之前,须要办理很多细节,个中有一些奇妙的地方。

另一个不随意马虎创造的地方是,任何开放(非私有)测试数据集都不可避免地泄露到演习集中。人们直觉上的强烈疑惑这一点,这也是最近GSM1k盛行的缘故原由。

纵然LLM开拓职员尽最大努力,防止测试集渗透到演习集(以及模型记住答案)也很困难。当然,你可以尽力过滤掉演习集中与测试集完备匹配的内容,还可以过滤掉n-gram识别的近似匹配。但是,如何过滤掉合成数据重写或网上对数据的谈论内容?如果定期演习多模态模型,如何过滤数据的图像/屏幕截图?如何防止开拓职员将演习数据(比如embedding)放到测试集中,并专门利用与测试集高度对齐(在向量空间)的数据进行演习?

末了一点是,并非所有我们关心的LLM任务都是可自动评估的(例如思考总结等),此时你希望让人类参与进来。但如何掌握所有涉及的变量?例如人类评估者在多大程度上关注实际答案内容,或者长度、笔墨风格,或者如何看待模型谢绝回答的行为等等。

不管若何,反直觉的一点是,良好的评估是困难的,且须要高度密集的事情,但非常主要,以是我很高兴看到更多的组织加入,努力做好这件事。

Karpathy指路了一个GitHub博客,磋商了为什么在Eleuther AI创建的公开LLM排行榜上,Llama模型得到的MMLU测评分数低于论文供应的数字。

项目地址:https://github.com/huggingface/blog/blob/main/open-llm-leaderboard-mmlu.md

此外,他谈到的测试数据透露问题,Open AI研究员Jason Wei在最新的一篇博客中也提到过。

文章地址:https://www.jasonwei.net/blog/evals

而且最近的一篇论文中有比较充分的证据。

论文地址:https://arxiv.org/html/2405.00332

他们创造,许多公开的模型在GSM-8K数据集上有明显的过拟合表现,而且在同类的GSK-1K上测试时,多数模型都会有很大程度的性能低落。

论文地址:https://arxiv.org/html/2405.00332